DeepSeek V3.2-exp: революция в снижении затрат на AI

Исследователи DeepSeek представили экспериментальную модель V3.2-exp, которая кардинально сокращает расходы на выполнение операций с длинным контекстом. Анонс состоялся на платформе Hugging Face вместе с публикацией научной работы на GitHub.

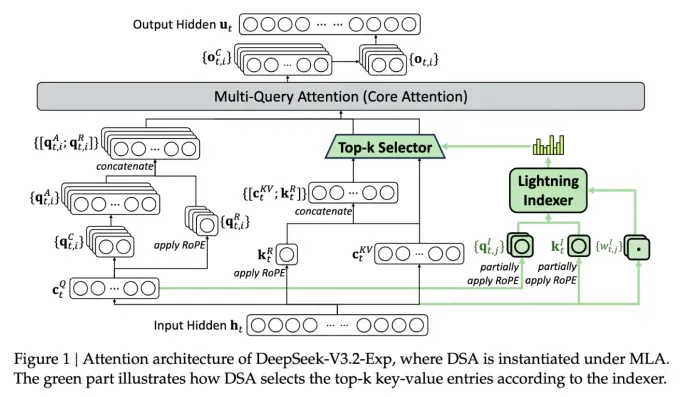

Ключевой особенностью новой модели стала система DeepSeek Sparse Attention. Она использует модуль «lightning indexer» для выбора наиболее релевантных фрагментов контекста. Затем система точного отбора токенов загружает в ограниченное окно внимания только самые важные элементы. Совместная работа этих механизмов позволяет обрабатывать объёмные данные с минимальной нагрузкой на сервер.

Предварительные тесты показали, что стоимость API-вызова в scenarios с длинным контекстом может снизиться вдвое. Хотя для окончательных выводов требуется дополнительная проверка, модель уже доступна в открытом доступе, и независимые эксперты скоро смогут оценить её эффективность.

Новая разработка DeepSeek продолжает серию прорывов в области сокращения inference costs — эксплуатационных расходов на работу AI-моделей. Исследователи сосредоточились на оптимизации архитектуры трансформеров, демонстрируя значительный потенциал для улучшений.

Базируясь в Китае, DeepSeek остается заметным игроком на мировой арене искусственного интеллекта. Ранее компания привлекла внимание моделью R1, обученной с помощью reinforcement learning при меньших затратах. Хотя та модель не вызвала глобальных изменений в индустрии, новая технология sparse attention может стать ценной находкой для снижения издержек у западных providers.

Галерея

Комментарии