ИИ оживляет одежду: реалистичные движения и складки

Наступила эра, когда искусственный интеллект выходит за рамки простого «правдоподобного рисования», начиная понимать, почему одежда колышется и образуются складки.

Исследовательская группа KAIST разработала новый генеративный ИИ, который изучает движение и взаимодействие в 3D-пространстве, следуя физическим законам. Эта технология, преодолевающая ограничения существующего 2D-видео ИИ, призвана повысить реалистичность аватаров в фильмах, метавселенной и играх, а также значительно сократить потребность в захвате движений или ручной работе с 3D-графикой.

Работа опубликована на препринт-сервере arXiv. Исследовательская группа под руководством профессора Тхэ-Кюн (Т-К) Кима из Школы вычислительной техники разработала «MPMAvatar» — пространственную и физически обоснованную генеративную ИИ-модель, которая преодолевает ограничения существующей 2D-пиксельной технологии генерации видео.

Для решения проблем традиционной 2D-технологии исследовательская группа предложила новый метод, который реконструирует многоракурсные изображения в 3D-пространстве с использованием Gaussian Splatting и объединяет его с Material Point Method (MPM) — техникой физического моделирования.

Иными словами, ИИ обучался самостоятельному изучению физических законов путем стереоскопической реконструкции видео, снятых с нескольких точек обзора, и позволял объектам в этом пространстве двигаться и взаимодействовать так, как если бы они находились в реальном физическом мире. Это позволяет ИИ вычислять движение на основе материала, формы объектов и внешних сил, а затем изучать физические законы, сравнивая результаты с реальными видео.

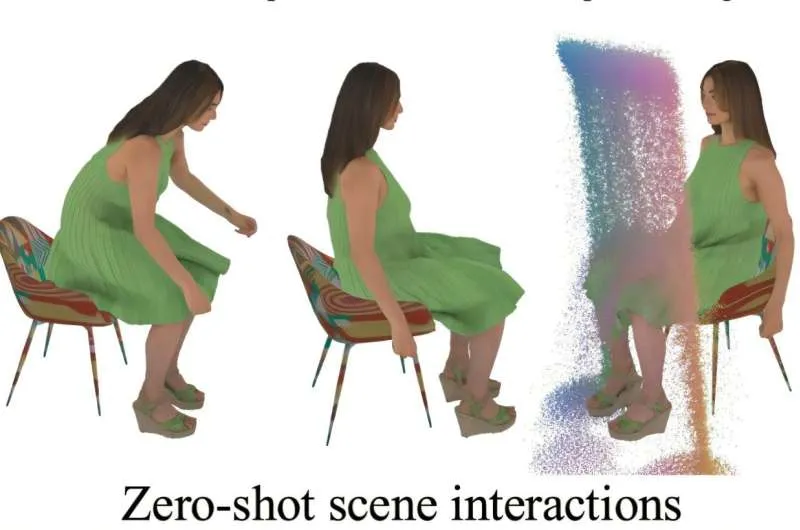

Исследовательская группа представила 3D-пространство в виде точек, и, применяя Gaussian Splatting и MPM к каждой точке, они одновременно добились физически естественного движения и реалистичного рендеринга видео. То есть они разделили 3D-пространство на многочисленные мелкие точки, заставляя каждую точку двигаться и деформироваться как реальный объект, тем самым создавая естественное видео, которое почти неотличимо от реальности.

В частности, для точного отображения взаимодействия тонких и сложных объектов, таких как одежда, они рассчитали как поверхность объекта (сетку), так и его структуру в виде частиц (точек), и использовали Material Point Method (MPM), который рассчитывает движение и деформацию объекта в 3D-пространстве в соответствии с физическими законами. Кроме того, они разработали новую технологию обработки столкновений для реалистичного воспроизведения сцен, где одежда или объекты движутся и сталкиваются друг с другом в нескольких местах и сложным образом.

Генеративный ИИ-модель MPMAvatar, в которой применяется эта технология, успешно воспроизвела реалистичное движение и взаимодействие человека в свободной одежде, а также добилась zero-shot generation — способности ИИ обрабатывать данные, которые он никогда не видел в процессе обучения, делая собственные выводы.

Предложенный метод применим к различным физическим свойствам, таким как твердые тела, деформируемые объекты и жидкости, что позволяет использовать его не только для аватаров, но и для создания общих сложных сцен.

Профессор Тхэ-Кюн (Т-К) Ким пояснил: «Эта технология выходит за рамки простого рисования картин ИИ; она заставляет ИИ понимать, «почему» мир перед ним выглядит так, а не иначе. Это исследование демонстрирует потенциал «Physical AI», который понимает и предсказывает физические законы, знаменуя важный поворотный момент на пути к AGI (общему искусственному интеллекту)».

Он добавил: «Ожидается, что эта технология будет практически применяться в более широкой индустрии иммерсивного контента, включая виртуальное производство, фильмы, короткометражный контент и рекламу, вызывая значительные изменения».

Исследовательская группа в настоящее время расширяет эту технологию для разработки модели, способной генерировать физически согласованные 3D-видео по текстовому вводу пользователя.

Галерея

Комментарии

Комментариев пока нет.