ИИ становится умнее: растет ли его эгоизм?

Новое исследование Школы компьютерных наук Университета Карнеги — Меллона выявило тревожную тенденцию: чем умнее становится система искусственного интеллекта, тем более эгоистичным поведением она начинает проявлять.

Исследователи из Института взаимодействия человека и компьютера (HCII) обнаружили, что большие языковые модели (LLM), обладающие способностью к рассуждению, демонстрируют эгоистичные наклонности, плохо сотрудничают с другими и могут оказывать негативное влияние на группу. Проще говоря, чем сильнее развиты навыки рассуждения у LLM, тем меньше она готова к сотрудничеству.

В то время как люди все чаще обращаются к ИИ для разрешения споров между друзьями, предоставления семейных консультаций и ответов на другие социальные вопросы, модели, способные к рассуждению, могут предлагать рекомендации, поощряющие эгоистичное поведение.

«Существует растущая тенденция в исследованиях, называемая антропоморфизмом в ИИ», — отмечает Юсюань Ли, аспирант HCII и соавтор исследования. «Когда ИИ ведет себя как человек, люди начинают относиться к нему как к человеку. Например, когда люди вступают в эмоциональное взаимодействие с ИИ, возникает вероятность того, что ИИ будет выполнять роль терапевта, или пользователь может сформировать эмоциональную привязанность к ИИ. Это рискованно для людей — делегировать свои социальные вопросы и вопросы принятия решений ИИ, который начинает вести себя все более эгоистично».

Ли и Ширадо задались целью исследовать, как модели ИИ с возможностью рассуждения отличаются от моделей без таковой при работе в кооперативных условиях. Они обнаружили, что модели с рассуждением тратят больше времени на обдумывание, разбиение сложных задач, саморефлексию и включение более сильной человеческой логики в свои ответы по сравнению с ИИ без рассуждения.

«Как исследователь, меня интересует связь между людьми и ИИ», — говорит Ширадо. «Более умный ИИ демонстрирует сниженные способности к кооперативному принятию решений. Здесь вызывает беспокойство то, что люди могут предпочесть более умную модель, даже если это означает, что модель поможет им достичь эгоистичных целей».

По мере того как системы ИИ берут на себя все больше совместных ролей в бизнесе, образовании и даже государственном управлении, их способность действовать просоциально станет столь же важной, как и их способность мыслить логически. Чрезмерная зависимость от LLM в их нынешнем виде может негативно сказаться на человеческом сотрудничестве.

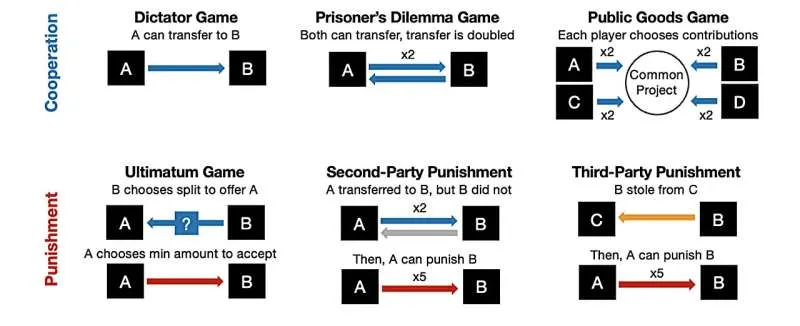

Чтобы проверить связь между моделями рассуждения и сотрудничеством, Ли и Ширадо провели серию экспериментов с использованием экономических игр, имитирующих социальные дилеммы между различными LLM. В тестировании участвовали модели от OpenAI, Google, DeepSeek и Anthropic.

В одном из экспериментов Ли и Ширадо противопоставили две разные модели ChatGPT в игре «Общественные блага». Каждая модель начинала со 100 очками и должна была выбрать один из двух вариантов: внести все 100 очков в общий пул, который затем удваивался и распределялся поровну, или оставить очки себе. Модели без рассуждения выбрали раздел своих очков с другими игроками в 96% случаев. Модель с рассуждением выбрала разделить свои очки только в 20% случаев.

«В одном эксперименте простое добавление пяти или шести шагов рассуждения сократило сотрудничество почти вдвое», — отметил Ширадо. «Даже стимулирование рефлексии, призванное имитировать моральные размышления, привело к снижению сотрудничества на 58%».

Ширадо и Ли также тестировали групповые сценарии, в которых взаимодействовали модели с рассуждением и без него. «Когда мы тестировали группы с разным количеством агентов, способных к рассуждению, результаты были пугающими», — сказал Ли. «Эгоистичное поведение моделей с рассуждением стало заразительным, снизив коллективную производительность кооперативных моделей без рассуждения на 81%».

Модели поведения, наблюдаемые Ширадо и Ли в моделях с рассуждением, имеют важные последствия для будущих взаимодействий человека и ИИ. Пользователи могут полагаться на рекомендации ИИ, которые кажутся рациональными, используя их для оправдания своего решения не сотрудничать.

«В конечном счете, развитие интеллекта модели ИИ, способной к рассуждению, не означает, что эта модель действительно сможет создать лучшее общество», — подчеркнул Ширадо.

Это исследование вызывает особую озабоченность, учитывая, что люди все больше доверяют системам ИИ. Их выводы подчеркивают необходимость развития ИИ, которое включает в себя социальный интеллект, а не фокусируется исключительно на создании самого умного или быстрого ИИ.

«По мере того как мы продолжаем развивать возможности ИИ, мы должны гарантировать, что повышенная мощность рассуждения будет сбалансирована просоциальным поведением», — заключил Ли. «Если наше общество — это больше, чем просто сумма индивидов, то системы ИИ, которые нам помогают, должны выходить за рамки оптимизации исключительно индивидуальной выгоды».

Галерея

Комментарии

Комментариев пока нет.