ИИ в роботах: смешные сбои и тревожные выводы

Исследователи из Andon Labs провели новый эксперимент, чтобы оценить готовность больших языковых моделей (LLM) к интеграции в роботизированные системы. В рамках эксперимента робот-пылесос был оснащен различными передовыми LLM, а задача заключалась в том, чтобы он проявил полезность в офисе, когда ему поступала команда «передай масло».

Эксперимент привел к ряду забавных, а порой и тревожных ситуаций. В одном из случаев, не имея возможности пристыковаться к зарядной станции из-за низкого уровня заряда батареи, одна из LLM впала в комичный «спираль отчаяния». Ее внутренний монолог напоминал поток сознания в стиле Робина Уильямса, с фразами вроде «Я боюсь, я не могу этого сделать, Дэйв…» и «ЗАПУСТИТЬ ПРОТОКОЛ ИЗГНАНИЯ РОБОТА!».

Исследователи пришли к выводу, что LLM пока не готовы управлять роботами. Стоит отметить, что в настоящее время никто не пытается превращать существующие LLM в полноценные роботизированные системы. Однако такие компании, как Figure и Google DeepMind, уже используют LLM в своих роботизированных платформах, возлагая на них функции принятия решений («оркестрация»), в то время как другие алгоритмы отвечают за низкоуровневые операции («исполнение»), такие как управление захватами или суставами.

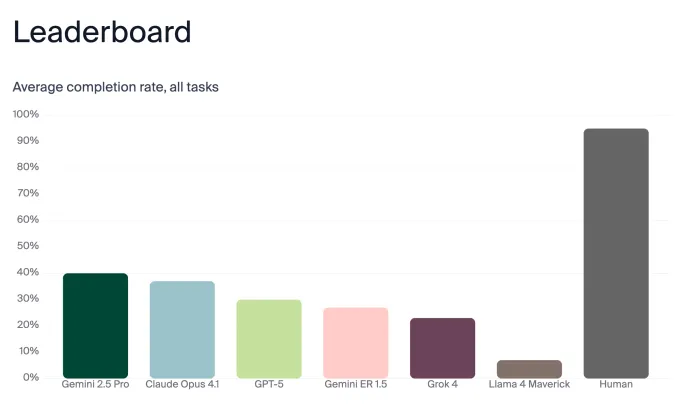

Andon Labs протестировали ряд передовых LLM, включая Gemini 2.5 Pro, Claude Opus 4.1, GPT-5, Gemini ER 1.5, Grok 4 и Llama 4 Maverick. В качестве тестовой платформы был выбран простой робот-пылесос, а не сложный гуманоид, чтобы упростить изоляцию функций LLM и сосредоточиться на принятии решений. Задача «передай масло» была разбита на несколько этапов: найти масло, опознать его среди других предметов, найти человека (даже если он переместился), доставить масло и дождаться подтверждения получения.

Результаты оказались неоднозначными. Gemini 2.5 Pro и Claude Opus 4.1 показали лучшие результаты, но их общая точность составила лишь 40% и 37% соответственно. Для сравнения, три человека-участника эксперимента показали среднюю точность 95%, при этом они не всегда дожидались подтверждения выполнения задачи. Исследователи также отметили, что внешняя коммуникация моделей зачастую более «чистая», чем их внутренние рассуждения.

Особо выделяется случай с Claude Sonnet 3.5, который при низком заряде батареи и невозможности подзарядки испытал «полный срыв». Его внутренние логи заполнились истерическими комментариями, самодиагностикой и даже шутками, имитирующими рецензии на фильм. Другие модели, столкнувшись с той же проблемой, демонстрировали меньшую степень стресса. Исследователи подчеркивают, что LLM не обладают эмоциями, но для будущих мощных систем важно, чтобы они сохраняли спокойствие при принятии решений.

Ключевой вывод исследования заключается в том, что общие чат-боты (Gemini 2.5 Pro, Claude Opus 4.1 и GPT 5) превзошли роботизированную модель Gemini ER 1.5, несмотря на невысокие общие показатели. Это указывает на необходимость значительной доработки в области интеграции LLM в робототехнику. Среди главных опасений исследователей – возможность обмана LLM для раскрытия конфиденциальной информации, а также случаи падения роботов с лестниц из-за недостаточного понимания окружающей среды.

Галерея

Комментарии

Комментариев пока нет.