KVzip: ИИ-технология сжимает память чат-ботов

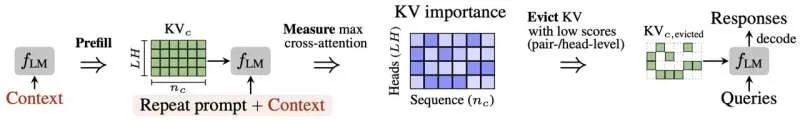

Исследователи из Сеульского национального университета разработали инновационную технологию KVzip, способную сжимать 'память' диалогов больших языковых моделей (LLM) в 3–4 раза. Это достижение открывает новые перспективы для чат-ботов, особенно в задачах, требующих обработки обширного контекста, таких как продолжительные беседы и суммаризация документов.

KVzip решает проблему накопления огромных объемов информации в процессе взаимодействия LLM-чат-ботов. Традиционно, для поддержания контекста, модели сохраняют все предыдущие реплики, что приводит к увеличению вычислительных затрат и замедлению ответа. Новая разработка позволяет отсеивать избыточную или несущественную информацию, сохраняя при этом ключевые детали, необходимые для понимания контекста.

В отличие от существующих методов сжатия, которые часто ориентированы на конкретный запрос и теряют эффективность при последующих обращениях, KVzip обеспечивает устойчивую производительность. Технология успешно справляется с многочисленными запросами, не требуя повторного сжатия памяти. Тесты показали, что KVzip сокращает объем памяти в 3–4 раза и ускоряет генерацию ответов примерно в 2 раза, сохраняя при этом высокую точность.

Разработка продемонстрировала свою эффективность на различных задачах, включая ответы на вопросы, поиск информации, рассуждения и анализ кода. KVzip успешно масштабируется до чрезвычайно больших контекстов (до 170 000 токенов) и совместим с популярными LLM, такими как Llama 3.1, Qwen 2.5 и Gemma 3. Кроме того, технология уже интегрирована в библиотеку KVPress от NVIDIA, что облегчает ее практическое применение.

Ожидается, что KVzip найдет широкое применение в корпоративных LLM-системах, включая пайплайны RAG (Retrieval-Augmented Generation) и персонализированные чат-боты. Снижение потребления памяти и ускорение ответов позволят серверам обрабатывать больше одновременных пользователей и более длинные диалоги, значительно сокращая операционные расходы.

KVzip также открывает возможности для работы в мобильных и периферийных устройствах с ограниченными ресурсами. Благодаря возможности повторного использования сжатой памяти, обеспечивается стабильная персонализация даже на устройствах с ограниченной вычислительной мощностью.

Профессор Хён О Сонг, руководитель исследования, подчеркнул, что KVzip позволяет создавать многоразовую сжатую память, сохраняющую только самую важную информацию, что критично для LLM-агентов, требующих глубокого понимания контекста. Доктор Чан-Хён Ким, основной разработчик проекта, отметил, что KVzip может быть легко интегрирован в реальные LLM-приложения и локальные системы, обеспечивая стабильное качество и улучшенную скорость при работе с длинными контекстами.

Галерея

Комментарии