LLM-студенты: новый подход к обучению нейросетей

Человеческий мозг обладает уникальной способностью к обучению, но большие языковые модели (LLM) сталкиваются с ограничениями: после обучения их «мозг» остается статичным и не может перманентно усваивать новую информацию. Это означает, что любая новая информация, полученная пользователем, будет забыта при следующем взаимодействии.

Исследователи из Массачусетского технологического института (MIT) разработали новаторский подход, позволяющий LLM самостоятельно адаптироваться и интегрировать новые знания. Подобно студентам, модели генерируют собственные «конспекты» на основе пользовательского ввода, которые затем используются для закрепления информации путем изменения внутренних параметров.

Этот метод подразумевает генерацию множества саморедактирований для обработки одного входного фрагмента. Затем модель оценивает каждое из них, определяя, какое из них наиболее эффективно улучшает ее производительность. Этот процесс проб и ошибок позволяет LLM научиться оптимальному способу собственного обучения.

Результаты показали значительное повышение точности LLM в задачах ответа на вопросы и распознавания образов. Более того, небольшая модель, обученная по этой методике, превзошла значительно более крупные аналоги.

Несмотря на существующие ограничения, эта технология может стать ключом к созданию искусственного интеллекта, способного непрерывно адаптироваться к новым задачам и достигать изменяющихся целей в динамичной среде.

«Сложные системы ИИ, как и люди, не могут оставаться статичными на протяжении всей своей жизни. LLM функционируют не в изолированной среде, они постоянно получают новые данные от пользователей. Наша цель — создать модель, более похожую на человека, способную к самосовершенствованию», — отмечает Джуотиш Пари, аспирант MIT и один из ведущих авторов исследования.

Обучение модели: новый взгляд

LLM представляют собой нейронные сети с миллиардами параметров, называемых весами, которые хранят знания модели и обрабатывают входные данные для генерации прогнозов. В процессе обучения эти веса корректируются для усвоения новой информации из обучающих данных. Однако после развертывания модели веса становятся фиксированными.

LLM демонстрируют высокую эффективность в так называемом «обучении в контексте», когда модель учится выполнять новую задачу на основе нескольких примеров. Хотя эти примеры влияют на ответы модели, полученные знания не сохраняются между сессиями.

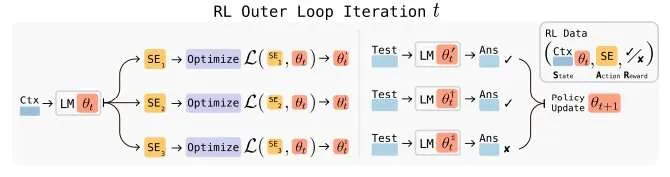

Исследователи MIT решили использовать возможности обучения в контексте для перманентного обновления весов LLM при столкновении с новой информацией. Разработанная ими система, получившая название SEAL (Self-Adapting LLMs), позволяет LLM генерировать синтетические данные на основе входных данных и определять наилучший способ адаптации для усвоения этих данных. Каждая единица синтетических данных представляет собой саморедактирование, которое модель может применить.

SEAL в действии

В контексте обработки языка LLM создает синтетические данные, переписывая информацию из входного текста и анализируя ее последствия. Это аналогично тому, как студенты создают конспекты, переписывая и резюмируя содержание лекций.

Модель выполняет эту операцию многократно, а затем «тестирует» себя по каждому саморедактированию, чтобы определить, какое из них привело к наибольшему улучшению производительности в конкретной задаче, например, в ответах на вопросы. Используется метод проб и ошибок, известный как обучение с подкреплением, где модель получает «вознаграждение» за наибольший прирост производительности.

Затем модель «запоминает» наилучший конспект, обновляя свои веса для интеграции информации из этого саморедактирования.

«Мы надеемся, что модель научится создавать наиболее эффективные конспекты — правильной длины и с достаточным разнообразием информации — таким образом, чтобы последующее обновление модели на их основе приводило к ее улучшению», — поясняет Цвейгер.

Выбор оптимального метода обучения

Система SEAL также предоставляет модели возможность выбирать предпочтительные методы обучения. Например, модель может выбирать синтетические данные, скорость обучения и количество итераций для обучения.

В этом сценарии модель не только генерирует собственные учебные данные, но и конфигурирует процесс оптимизации, который применяет эти саморедактирования к ее весам.

«Мы хотим наделить большие языковые модели способностью выбирать, как лучше всего усваивать информацию, подобно тому, как это делаем мы, люди. Предоставляя модели контроль над процессом обработки информации, мы позволяем ей самостоятельно определять наилучший способ анализа поступающих данных», — говорит Пари.

SEAL продемонстрировал превосходство над несколькими базовыми методами в широком спектре задач, включая освоение новых навыков на основе нескольких примеров и интеграцию знаний из текстовых фрагментов. В задачах ответа на вопросы SEAL повысил точность модели почти на 15%, а в некоторых задачах обучения навыкам — более чем на 50%.

Однако одним из ограничений этого подхода является проблема «катастрофического забывания»: при постоянном обновлении модели ее производительность в ранее освоенных задачах постепенно снижается.

Исследователи планируют в будущих работах устранить это явление. Кроме того, они намерены применить эту технику в многоагентной среде, где несколько LLM будут обучаться друг у друга.

«Одним из ключевых препятствий для LLM, способных проводить значимые научные исследования, является их неспособность обновляться на основе взаимодействия с новой информацией. Хотя полностью развернутые самоадаптирующиеся модели еще далеки от реализации, мы надеемся, что системы, способные обучаться таким образом, в конечном итоге преодолеют это ограничение и помогут продвинуть науку вперед», — заключает Цвейгер.

Галерея

Комментарии

Комментариев пока нет.